X-Robots-Tag

I en tid hvor digital tilstedeværelse er avgjørende for suksess, er det viktig å forstå hvordan man kan styre hvordan nettsider blir indeksert av søkemotorer. En av de mest nyttige, men kanskje mindre kjente, verktøyene i denne prosessen er "X-Robots-Tag". Dette verktøyet gir webutviklere og SEO-eksperter en ekstra grad av kontroll over hvordan innholdet deres blir behandlet av søkemotorer. I denne artikkelen vil vi utforske hva X-Robots-Tag er, hvordan det kan påvirke indekseringsprosessen, og hvordan du kan implementere det på din egen nettside.

Utforskning av X-Robots-Tag: En Introduksjon

X-Robots-Tag er en HTTP-header som gir webmastere muligheten til å kontrollere hvordan nettsiders innhold blir indeksert av søkemotorer som Google, Bing, og andre. I motsetning til den mer kjente robots.txt-filen, som gir instruksjoner på et globalt nivå for hele nettsiden, kan X-Robots-Tag brukes til å gi spesifikke direktiver for individuelle filer eller ressurser. Dette kan inkludere bilder, PDF-dokumenter, eller andre typer filer som vanligvis ikke ville bli dekket av standard meta-tags.

En av de mest bemerkelsesverdige fordelene med X-Robots-Tag er fleksibiliteten den gir. Mens meta-taggen "robots" er begrenset til HTML-dokumenter, kan X-Robots-Tag settes i HTTP-responsen for hvilken som helst filtype. Dette betyr at du kan bruke det til å kontrollere indekseringen av bilder, videoer, eller til og med CSS- og JavaScript-filer. Denne evnen til å gi direktiver på et mer granular nivå kan være uvurderlig for nettsteder som ønsker å optimalisere sin synlighet og ytelse i søkemotorresultater.

Det er også viktig å merke seg at X-Robots-Tag kan brukes til å forhindre at visse typer innhold indekseres, noe som kan være nyttig for å beskytte sensitiv informasjon eller forhindre duplisert innhold fra å påvirke SEO-ytelsen negativt. For eksempel, hvis du har en PDF-fil med informasjon som ikke er relevant for offentlig søk, kan du bruke X-Robots-Tag til å sikre at den ikke blir indeksert.

Til tross for sin kraft og fleksibilitet, er det viktig å bruke X-Robots-Tag med forsiktighet. Feil implementering kan føre til at viktig innhold ikke blir indeksert, noe som kan ha en negativ innvirkning på nettsidens synlighet. Derfor er det avgjørende å ha en klar forståelse av hvordan denne taggen fungerer før du integrerer den i din nettsides strategi.

Hvordan X-Robots-Tag Endrer Nettsideindeksering

X-Robots-Tag har en betydelig innvirkning på hvordan nettsider blir indeksert av søkemotorer. Ved å bruke denne taggen kan webmastere spesifisere om en side eller en ressurs skal indekseres, følges eller ignoreres helt. Dette gir en høy grad av kontroll over hva som blir synlig i søkemotorresultater, og kan bidra til å forbedre både rangering og relevans.

En av de mest vanlige bruksområdene for X-Robots-Tag er å hindre duplisert innhold fra å bli indeksert. Duplisert innhold kan forvirre søkemotorer og føre til lavere rangeringer. Ved å bruke X-Robots-Tag til å angi "noindex" eller "nofollow" på dupliserte sider, kan man unngå disse problemene og sikre at kun det mest relevante innholdet blir indeksert.

Videre kan X-Robots-Tag brukes til å beskytte sensitiv informasjon fra å bli indeksert. Dette kan være spesielt viktig for nettsider som håndterer personlig informasjon eller konfidensielle data. Ved å bruke taggen til å ekskludere slike filer fra indeksering, kan man redusere risikoen for at sensitiv informasjon blir tilgjengelig via søkemotorer.

En annen viktig funksjon av X-Robots-Tag er muligheten til å forbedre nettsidens ytelse. Ved å hindre unødvendig indeksering av ressurser som ikke bidrar til SEO-verdien, som visse typer skript eller stilark, kan man optimalisere lastetiden og ressursbruken på nettsiden. Dette kan føre til bedre brukeropplevelser og potensielt høyere rangeringer i søkemotorer.

Implementering av X-Robots-Tag i Din Nettside

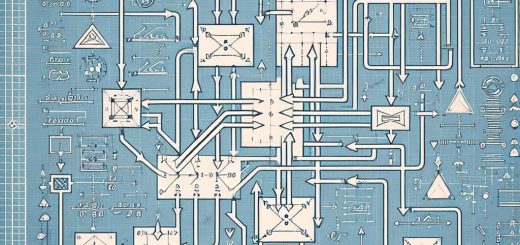

Å implementere X-Robots-Tag på din nettside krever en forståelse av hvordan HTTP-headere fungerer, samt hvordan du kan konfigurere serveren din til å sende disse headerne. Det første trinnet er å identifisere hvilke ressurser eller sider du ønsker å kontrollere indekseringen for. Dette kan variere fra bilder og videoer til dokumenter og andre filer som ikke er HTML-baserte.

Når du har identifisert ressursene, kan du konfigurere serveren din til å inkludere X-Robots-Tag i HTTP-responsen. For Apache-servere kan dette gjøres ved å legge til direktiver i .htaccess-filen, mens for Nginx kan det gjøres i konfigurasjonsfilene. Eksempelvis kan du bruke direktivet "Header set X-Robots-Tag" i Apache for å angi direktiver som "noindex", "nofollow", eller "noarchive" for spesifikke filer eller kataloger.

Det er også viktig å teste implementeringen for å sikre at den fungerer som forventet. Dette kan gjøres ved å bruke verktøy som "Fetch as Google" i Google Search Console, eller ved å analysere HTTP-headerne som serveren returnerer. Testing er avgjørende for å unngå feil som kan føre til at viktig innhold blir feilaktig ekskludert fra indeksering.

Til slutt, bør du kontinuerlig overvåke hvordan endringene påvirker nettsidens SEO-ytelse. Dette innebærer å holde øye med rangeringer, trafikk, og indekseringsstatus i verktøy som Google Analytics og Google Search Console. Ved å være proaktiv kan du justere strategien din for å sikre at nettsiden din oppnår optimal synlighet og ytelse i søkemotorer.

X-Robots-Tag representerer et kraftig verktøy i arsenalet til enhver webmaster eller SEO-ekspert som ønsker å finjustere hvordan innholdet deres blir oppfattet av søkemotorer. Ved å gi en høy grad av kontroll over indekseringsprosessen, kan det bidra til å forbedre synligheten, beskytte sensitiv informasjon, og optimere nettsidens ytelse. Men som med alle verktøy, krever det en grundig forståelse og nøye implementering for å utnytte dets fulle potensial. For de som er villige til å investere tid og innsats, kan X-Robots-Tag være en nøkkelkomponent i en vellykket digital strategi.